Imaginez un instant : nous sommes en janvier 2026, les projecteurs du CES s’allument sur une scène où un homme discret mais charismatique annonce tranquillement que l’humanité vient de franchir une nouvelle étape dans la course à l’intelligence artificielle. Cet homme, c’est Jensen Huang. L’annonce ? La mise en production officielle de l’architecture Rubin, la nouvelle arme absolue de Nvidia face à l’explosion des besoins en calcul IA. Et si cette puce changeait vraiment la donne pour les prochaines années ?

Rubin : quand Nvidia redéfinit l’avenir du calcul IA

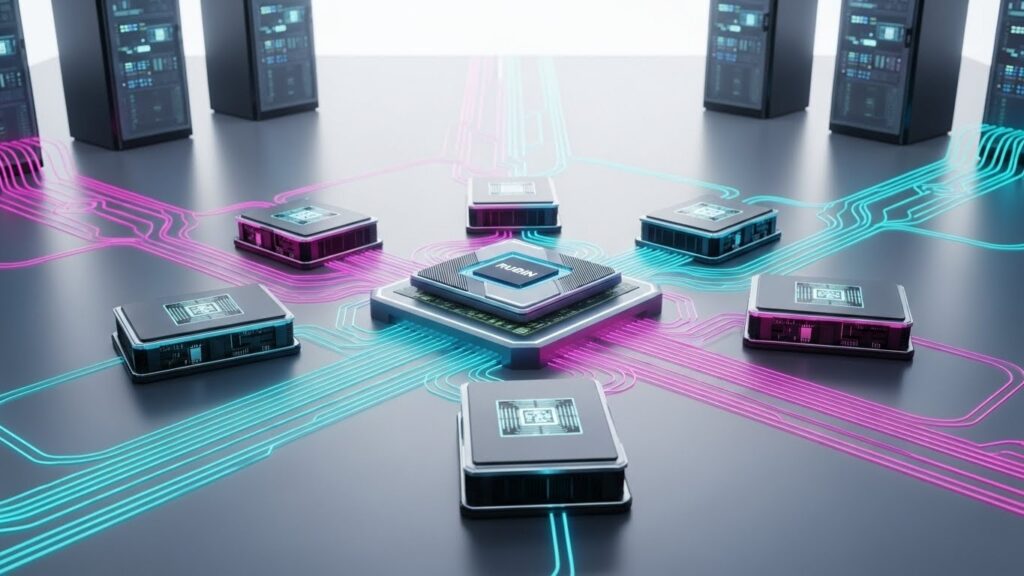

Depuis plus de dix ans, Nvidia impose un rythme infernal dans le domaine des accélérateurs graphiques pour l’intelligence artificielle. Chaque nouvelle génération semble repousser les limites que l’on croyait infranchissables. Après les architectures Lovelace, Hopper puis Blackwell, voici donc venue l’ère Rubin. Mais cette fois, il ne s’agit pas seulement d’une puce plus rapide : c’est un système complet pensé pour répondre aux nouveaux défis posés par les modèles d’IA toujours plus gourmands et complexes.

Le nom choisi n’est pas anodin. Vera Rubin, astronome américaine qui a démontré l’existence de la matière noire grâce à ses observations des courbes de rotation des galaxies, symbolise parfaitement cette quête de compréhension des phénomènes invisibles mais déterminants. Chez Nvidia, on aime les symboles forts.

Six composants pour une architecture unifiée

L’architecture Rubin ne se résume pas à un GPU boosté. Elle repose sur six éléments soigneusement orchestrés :

- Le GPU Rubin, cœur battant du système

- Le CPU Vera, spécialement conçu pour le raisonnement agentique

- Bluefield nouvelle génération pour le stockage et le réseau

- NVLink ultra-rapide repensé pour les interconnexions massives

- Une mémoire cache externe dédiée aux KV caches des grands modèles

- Un ensemble de contrôleurs et d’accélérateurs spécifiques aux nouvelles charges IA

Cette approche modulaire permet de s’adapter beaucoup plus finement aux différents types de workloads que l’on rencontre en 2026 : entraînement de modèles géants, inférence à très grande échelle, agents autonomes longue durée, simulation physique en temps réel, etc.

« Vera Rubin est conçue pour répondre à ce défi fondamental : la quantité de calcul nécessaire pour l’IA explose littéralement. »

Jensen Huang, CES 2026

Des performances qui font tourner la tête

Les chiffres communiqués par Nvidia lors de la keynote sont impressionnants. Comparé à Blackwell (lui-même considéré comme monstrueux un an plus tôt), Rubin affiche :

- x3,5 en vitesse d’entraînement des modèles

- x5 en vitesse d’inférence

- jusqu’à 50 pétaflops en performance crête sur certaines tâches

- x8 plus d’inférence par watt consommé

Ces gains ne viennent pas seulement d’une gravure plus fine ou de transistors supplémentaires. Ils résultent surtout d’une refonte profonde de l’architecture mémoire et des interconnexions. Le goulot d’étranglement principal des grands modèles n’est plus forcément le calcul brut, mais bien la capacité à déplacer rapidement des téraoctets de données entre les différents niveaux de mémoire.

Le KV cache externalisé : la vraie révolution ?

Pour comprendre l’importance de cette nouvelle couche de stockage, il faut plonger un instant dans le fonctionnement interne des transformers modernes. Le mécanisme d’attention repose sur ce qu’on appelle le KV cache (Key-Value cache) : une mémoire qui conserve les représentations des tokens déjà traités afin d’éviter de tout recalculer à chaque nouveau token généré.

Plus la conversation ou la tâche est longue, plus ce cache grossit. Avec les agents IA autonomes capables de raisonner sur des centaines voire des milliers d’échanges, ce cache peut atteindre des dizaines voire des centaines de Go par utilisateur. Stocker tout cela sur la mémoire HBM ultra-rapide mais très chère du GPU devient prohibitif.

C’est là qu’intervient la grande nouveauté de Rubin : une mémoire cache externe, connectée via des liens ultra-rapides, qui permet de déporter une grande partie du KV cache sans sacrifier trop de latence. Résultat : on peut multiplier par 10 ou plus la durée des contextes sans exploser le coût du système.

« Les nouveaux workflows comme l’IA agentique ou les tâches de très longue durée exercent une pression énorme sur le KV cache. Nous avons donc créé un nouveau niveau de stockage externe qui permet d’étendre le pool de manière beaucoup plus efficace. »

Dion Harris, Senior Director AI Infrastructure, Nvidia

Vera CPU : le cerveau des agents intelligents

Autre composant intrigant : le CPU Vera. Contrairement aux Grace CPU qui équipaient déjà certaines solutions Blackwell, Vera a été pensé dès le départ pour les charges d’IA agentique. Cela signifie qu’il excelle dans :

- l’exécution rapide de boucles de raisonnement complexes

- la gestion de très nombreux outils et APIs externes

- le maintien d’un état cohérent sur de longues périodes

- la planification et la décomposition de tâches complexes

Bien que Nvidia reste discret sur les détails micro-architecturaux, plusieurs experts estiment que Vera intègre des mécanismes d’exécution spéculative très avancés ainsi que des accélérateurs dédiés aux opérations symboliques et logiques, domaines où les GPU traditionnels marquent le pas.

Un écosystème déjà conquis

Si les annonces techniques sont toujours impressionnantes chez Nvidia, ce qui frappe encore plus en 2026, c’est la rapidité avec laquelle l’industrie adopte les nouvelles architectures. À peine dévoilée, Rubin est déjà prévue dans les feuilles de route des principaux acteurs :

- OpenAI prépare ses prochains datacenters autour de Rubin

- Anthropic mise gros sur cette plateforme pour accélérer Claude 4 et ses agents

- Amazon Web Services annonce des instances Rubin dès le second semestre 2026

- Google Cloud et Microsoft Azure ne sont pas en reste

- Le superordinateur Doudna de Berkeley Lab passera à Rubin

- HPE intègre la plateforme dans son futur Blue Lion

Cette adoption quasi unanime montre à quel point l’écosystème IA dépend désormais des innovations matérielles de Nvidia. Une dépendance qui pose d’ailleurs question à beaucoup d’observateurs.

Compétition et défis à venir

Malgré sa domination écrasante, Nvidia n’est plus totalement seul. AMD avec MI400 series, Intel avec Gaudi 3, les startups Groq, Cerebras, SambaNova, Tenstorrent, et même les puces maison des hyperscalers (TPU v6, Trainium 2, etc.) commencent à grignoter des parts de marché, surtout sur l’inférence.

Mais Rubin semble avoir repris une avance considérable, notamment grâce à son écosystème logiciel CUDA toujours inégalé et à ses interconnexions NVLink qui restent très difficiles à égaler pour les concurrents.

Reste la question énergétique. Les salles de plusieurs dizaines de milliers de GPU Rubin consommeront des centaines de mégawatts. Les fournisseurs d’électricité, les fabricants de refroidissement liquide et les spécialistes de la gestion thermique sont déjà en train de revoir leurs offres à la hausse pour accompagner cette nouvelle vague.

Vers un monde d’agents IA omniprésents

Ce qui se joue avec Rubin va bien au-delà d’une simple course aux benchmarks. L’architecture est clairement pensée pour rendre viable et économique l’exécution d’agents IA autonomes capables de travailler des heures, voire des jours sur des tâches complexes impliquant planification, utilisation d’outils, mémoire longue durée et raisonnement multi-étapes.

Si ces agents deviennent réellement performants et abordables à l’échelle, nous pourrions assister à une transformation profonde de nombreux secteurs : recherche scientifique assistée, développement logiciel autonome, gestion d’entreprise déléguée à des équipes d’agents, médecine personnalisée en temps réel, etc.

Nous ne sommes qu’au tout début de cette transition. Rubin n’est pas une fin en soi, mais plutôt une étape supplémentaire vers des systèmes qui ressembleront de plus en plus à une véritable intelligence générale… du moins dans certains domaines bien définis.

Conclusion : l’accélération ne fait que commencer

En dévoilant Rubin au CES 2026, Nvidia ne se contente pas d’annoncer une nouvelle puce. L’entreprise dessine les contours du prochain chapitre de l’intelligence artificielle : celui des agents autonomes massivement parallèles, dotés de mémoire persistante et d’une efficacité énergétique repensée.

Les mois et années à venir s’annoncent passionnants… et un peu vertigineux. Car à chaque nouvelle génération de matériel, ce sont de nouvelles possibilités qui s’ouvrent, mais aussi de nouveaux risques et questionnements éthiques.

Une chose est sûre : la course au calcul IA ne ralentit pas. Elle s’accélère. Et Rubin vient de donner un sérieux coup d’accélérateur.

(environ 3400 mots)